Meilleur GPU pour l'IA : comment choisir celui qui convient à votre travail

Le paysage de l'intelligence artificielle a évolué rapidement. Que vous entraîniez des modèles de langage de grande taille (LLMs) ou que vous soyez un créateur cherchant à améliorer des vidéos 4K, choisir le meilleur GPU pour l'IA est la décision matérielle la plus importante que vous prendrez. En 2026, le marché est plus diversifié que jamais, avec des silicones spécialisés conçus pour gérer tout, des réseaux neuronaux massifs à l'art génératif en temps réel.

Partie 1. Qu'est-ce qui rend un GPU bon pour l'IA ?

Tous les cartes graphiques ne sont pas créées égales en ce qui concerne l'apprentissage automatique. Pour trouver la meilleure carte graphique pour l'IA, vous devez aller au-delà des benchmarks de jeux et vous concentrer sur les métriques "Compute".

Caractéristiques clés qui comptent pour l'IA

- Support CUDA / ROCm : Le CUDA de NVIDIA reste la norme de l'industrie, faisant d'un GPU NVIDIA pour l'entraînement de l'IA le choix le plus compatible pour la plupart des bibliothèques comme PyTorch et TensorFlow.

- Taille de la VRAM (8 Go / 12 Go / 24 Go+) : La mémoire vidéo détermine la taille du modèle que vous pouvez charger. Pour les GPU pour l'apprentissage profond, 24 Go est le "sweet spot" pour les stations de travail locales, tandis que les tâches d'entreprise nécessitent 80 Go ou plus.

- Cores Tensor / Accélérateurs AI : Ce sont des unités matérielles spécialisées conçues pour la multiplication de matrices - les "mathématiques" de l'IA.

- Largeur de bande mémoire : Une large bande passante (mesurée en Go/s) garantit que les données circulent rapidement entre la mémoire et les cœurs, évitant les goulets d'étranglement.

- Considérations sur l'alimentation et le refroidissement : Les tâches d'IA fonctionnent souvent à 100 % de charge pendant des heures ou des jours ; une gestion thermique robuste est essentielle.

Entraînement vs. Inférence vs. Création AI

- Entraînement : Nécessite la plus haute VRAM et une évolutivité multi-GPU (NVLink) pour construire des modèles à partir de zéro.

- Inférence : Exécution d'un modèle pré-entraîné. Priorise la stabilité et le coût par requête.

- Créateurs AI : Se concentrent sur la meilleure performance GPU AI au sein des logiciels créatifs. Ces utilisateurs tirent le plus de bénéfices de l'accélération GPU dans des outils conviviaux qui gèrent l'amélioration vidéo et d'images.

Partie 2. Meilleurs GPU pour l'IA par cas d'utilisation (2026)

Sélectionner le meilleur GPU pour l'IA nécessite d'associer votre charge de travail spécifique au bon niveau matériel. Voici les principaux candidats pour 2026.

1. Meilleur GPU pour l'entraînement IA (Professionnel & Entreprise)

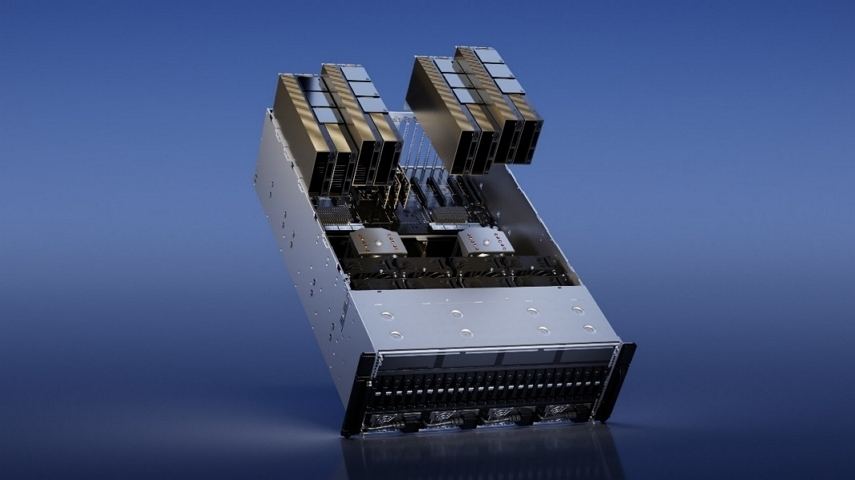

NVIDIA H100 / H200 Tensor Core

La série H représente le summum des GPU NVIDIA pour l'entraînement de l'IA. Le H200, en particulier, est un raffinement de l'architecture H100, offrant presque le double de la capacité pour les modèles de langage de grande taille (LLMs).

Idéal pour : Les centres de données, les institutions de recherche et les entreprises formant des modèles à un milliard de paramètres à partir de zéro.

Caractéristiques clés :

- Date de lancement : H100 (Oct 2022) / H200 (Nov 2024)

- Architecture : Hopper

- Mémoire : Jusqu'à 141 Go HBM3e (H200)

- Largeur de bande mémoire : 8 To/s

- Performance des Tensor Cores : ~3,958 TFLOPS (FP8 avec sparsité)

- Alimentation (TDP) : Jusqu'à 700W (SXM) / 350-600W (PCIe)

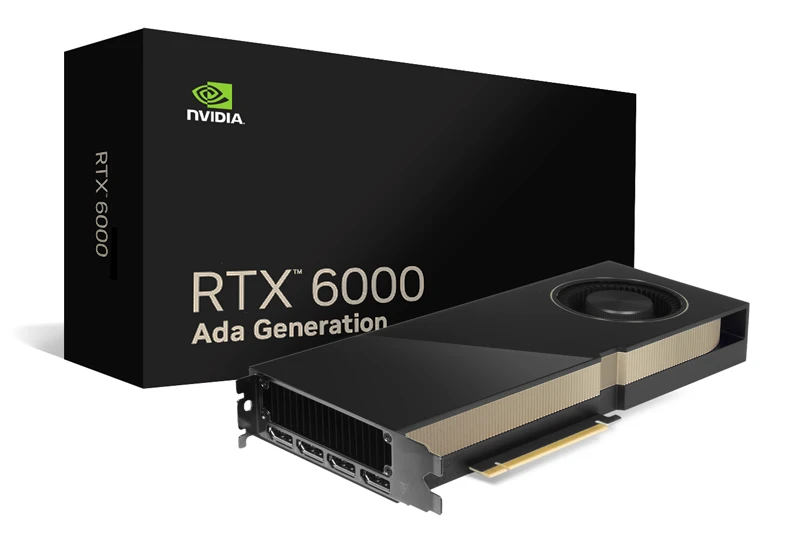

RTX 6000 génération Ada

C'est la carte de station de travail professionnelle ultime. Elle embarque presque le même "cerveau" que le RTX 4090 mais avec le double de la VRAM et un support de pilote professionnel.

Idéal pour : Les chercheurs et ingénieurs en IA ayant besoin d'une haute VRAM sur une station de travail locale pour le fine-tuning.

Caractéristiques clés :

- Date de lancement : Déc 2022

- Architecture : Ada Lovelace

- Mémoire : 48 Go GDDR6

- Largeur de bande mémoire : 960 Go/s

- Performance des Tensor Cores : 1,457 TFLOPS (Sparse)

- Alimentation (TDP) : 300W

2. Meilleur GPU pour l'inférence et le déploiement IA

NVIDIA RTX 4090

Considéré comme la meilleure carte graphique pour l'IA pour les consommateurs, les 24 Go de VRAM du 4090 en font la norme pour l'inférence locale LLM.

Idéal pour : Développeurs IA indépendants et utilisateurs de haute puissance.

Caractéristiques clés :

- Date de lancement : Sept 2022

- Architecture : Ada Lovelace

- Mémoire : 24 Go GDDR6X

- Largeur de bande mémoire : 1,01 To/s

- Performance des Tensor Cores : 1,321 TFLOPS (Sparse)

- Alimentation (TDP) : 450W

RTX 3090 (Le cheval de bataille de valeur)

En 2026, le 3090 reste un choix de premier plan pour le GPU pour l'apprentissage profond car il offre 24 Go de VRAM à une fraction du coût des cartes de la série 40.

Idéal pour : Étudiants et chercheurs soucieux de leur budget.

Caractéristiques clés :

- Date de lancement : Sept 2020

- Architecture : Ampere

- Mémoire : 24 Go GDDR6X

- Largeur de bande mémoire : 936 Go/s

- Performance des Tensor Cores : 564 TFLOPS (Sparse)

- Alimentation (TDP) : 350W

3. Meilleur GPU pour les créateurs IA (Vidéo, Image & IA générative)

NVIDIA RTX 4070

Le RTX 4070 est l'un des choix les plus équilibrés pour les créateurs IA. Il fournit suffisamment de VRAM et de performance des Tensor Cores pour gérer efficacement l'upscaling vidéo IA, l'amélioration d'images et les flux de travail d'IA générative.

Meilleur pour :

- Amélioration vidéo IA

- Génération d'images et d'animations

- Créateurs de contenu

Caractéristiques clés :

- Date de lancement : Avril 2023

- Architecture : Ada Lovelace

- Mémoire : 12 Go GDDR6X

- Largeur de bande mémoire : 504 Go/s

- Performance des Tensor Cores : 466 TFLOPS (Sparse)

- Alimentation (TDP) : 200W

RTX 4060 Ti (Version 16 Go)

Le RTX 4060 Ti est une option d'entrée de gamme pour les créateurs IA et les débutants. Bien qu'il soit limité en VRAM, il offre toujours une solide accélération IA pour des charges de travail plus légères telles que l'amélioration d'images IA et le traitement de courtes vidéos.

Meilleur pour :

- Nouveaux créateurs IA

- Apprentissage des flux de travail IA

Caractéristiques clés :

- Date de lancement : Mai 2023

- Architecture : Ada Lovelace

- Mémoire : 16 Go GDDR6

- Largeur de bande mémoire : 288 Go/s

- Performance des Tensor Cores : 353 TFLOPS (Sparse)

- Alimentation (TDP) : 165W

Partie 3. Astuce pro : Accélérez les tâches IA avec des logiciels optimisés pour GPU

Bien avoir le meilleur GPU pour l'apprentissage profond est une excellente base, le logiciel que vous utilisez détermine votre productivité réelle. Pour les créateurs spécifiquement, la performance matérielle peut souvent être limitée par des outils mal optimisés.

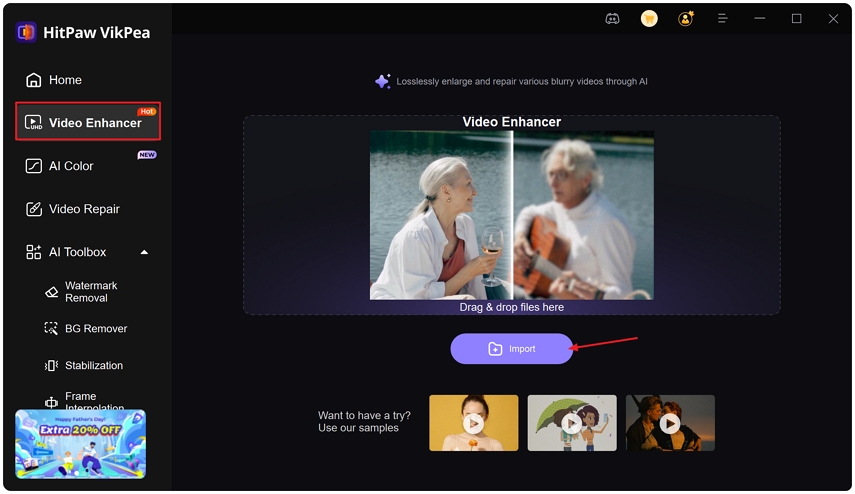

HitPaw VikPea est une suite d'amélioration vidéo alimentée par l'IA entièrement optimisée pour l'accélération GPU. Que vous utilisiez un RTX 4090 ou un 4060 Ti plus modeste, VikPea utilise les Tensor Cores de votre carte NVIDIA pour traiter les tâches jusqu'à 30 fois plus rapidement que les logiciels traditionnels basés sur CPU.

Fonctionnalités clés de HitPaw VikPea :

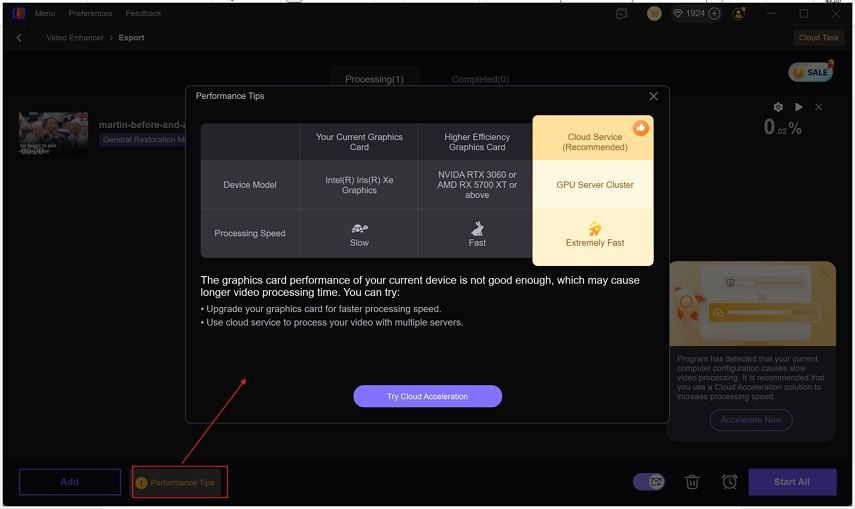

- Puissance hybride : Il prend en charge à la fois l'accélération GPU locale et le cloud computing, vous permettant de décharger les tâches lourdes lorsque votre matériel local est occupé.

- Upscaling vidéo 4K : Transformer des séquences 1080p granuleuses en 4K cinématographique n'a jamais été aussi rapide.

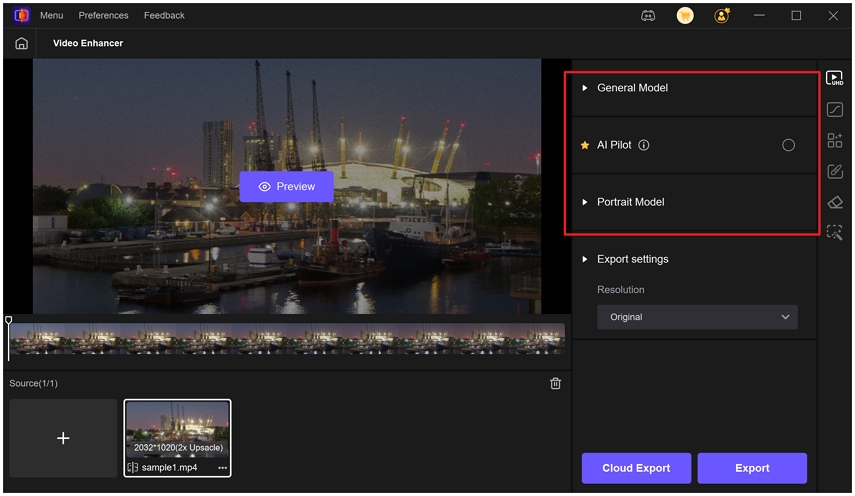

- Modèles IA ciblés : Vikpea propose des modèles spécialisés, tels que le modèle général pour la clarté globale ; le modèle de débruitage pour éliminer le bruit visuel des séquences en basse lumière ; le modèle portrait pour améliorer les détails du visage et les textures de la peau, etc.

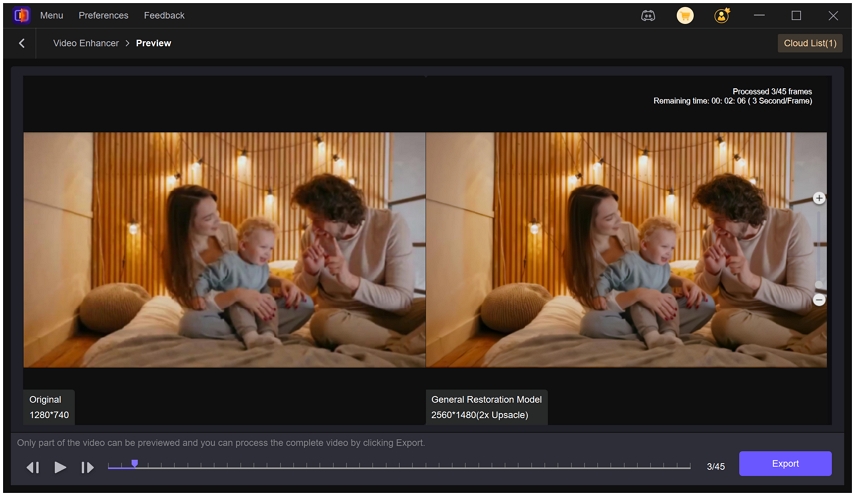

- Aperçu en temps réel : Voyez l'IA en action avec une vue écran partagé avant de vous engager dans l'exportation finale.

Guide étape par étape pour améliorer une vidéo avec un GPU

Étape 1. Lancer & Importer :

Ouvrez Vikpea et faites glisser votre vidéo dans le module Améliorateur vidéo.

Étape 2. Sélectionner le modèle : Choisissez le modèle IA qui correspond à votre séquence (par exemple, Portrait pour les vlogs).

Étape 3. Aperçu : Cliquez sur le bouton Aperçu pour voir un aperçu en temps réel côte à côte des effets.

Étape 4. Exporter avec Accélération : Cliquez sur le bouton Exporter pour commencer à traiter la vidéo entière. VikPea utilisera par défaut la carte graphique de votre ordinateur. Si vous sélectionnez l'Exportation Cloud, le processus sera encore plus rapide.

Partie 4. FAQ sur la carte graphique pour l'IA

Cela dépend de votre échelle. Pour un usage personnel et une recherche, le RTX 4090 est le meilleur GPU IA. Pour l'entraînement en entreprise, le NVIDIA H200 est la norme actuelle.

Non. Le RTX 4070 a significativement plus de cœurs CUDA et une largeur de bande mémoire plus élevée, le rendant beaucoup plus efficace pour les tâches d'apprentissage profond.

Au minimum, visez un GPU avec 8 Go de VRAM pour une inférence de base. Pour l'entraînement, 24 Go est fortement recommandé.

OpenAI utilise d'énormes clusters de GPU NVIDIA H100 et A100 pour entraîner des modèles comme GPT-4 et Sora.

NVIDIA est actuellement supérieur en raison de l'écosystème CUDA, qui est la plateforme logicielle la plus largement supportée pour le développement IA.

Conclusion

Choisir le meilleur GPU pour l'apprentissage profond ou la création de contenu nécessite d'équilibrer la VRAM, la puissance de calcul et la compatibilité logicielle. Bien que NVIDIA soit en tête du peloton en matière de matériel, des outils comme VikPea garantissent que vous tirez le meilleur parti de votre investissement grâce à une accélération GPU optimisée.

Laissez un avis

Donnez votre avis pour les articles HitPaw